实时数据概述

实时数据分析是指对正在发生的数据进行即时处理和分析的过程。这种分析方式在现代企业和组织中越来越重要,因为它能够帮助企业快速响应市场变化、优化业务流程和提升决策效率。实时数据通常来源于各种传感器、网络日志、交易系统等,它们以极高的速度产生,需要高效的处理和分析方法。

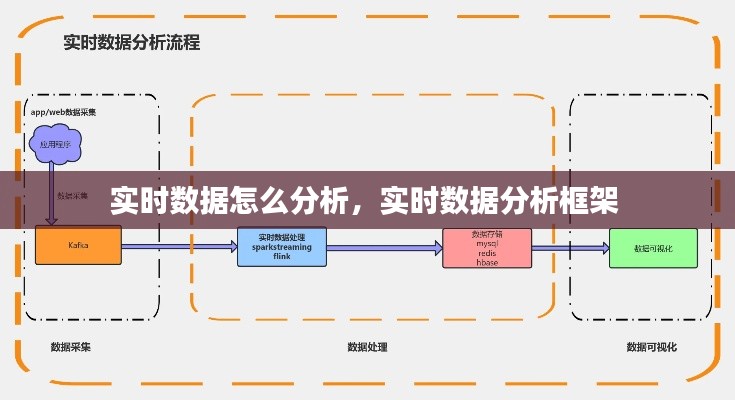

实时数据分析的关键步骤

实时数据分析通常包括以下几个关键步骤:

数据采集:从各种数据源收集实时数据,这可能涉及使用API、数据库连接或其他数据接入技术。

数据预处理:对采集到的数据进行清洗、转换和标准化,以确保数据的质量和一致性。

实时处理:使用流处理技术对数据进行实时处理,如使用Apache Kafka、Apache Flink或Spark Streaming等工具。

数据分析:应用统计模型、机器学习算法或其他分析技术对数据进行深入分析。

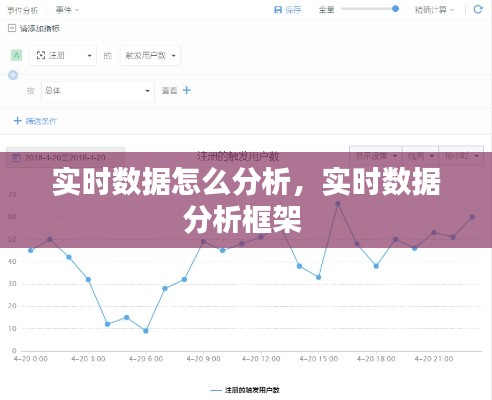

可视化与报告:将分析结果以图表、仪表板或其他形式展示给用户,以便于理解和决策。

数据采集与预处理

数据采集是实时数据分析的第一步,它涉及到从多个来源收集数据。这可以通过以下方式实现:

使用传感器和设备:在工厂、零售店或其他环境中部署传感器,以收集温度、湿度、流量等实时数据。

网络日志分析:从网络设备中收集日志数据,以分析网络流量、安全事件等。

交易系统接入:直接从交易系统中提取数据,以分析交易行为和趋势。

数据预处理是确保数据质量的关键步骤。它包括以下任务:

数据清洗:去除重复数据、处理缺失值和异常值。

数据转换:将数据转换为统一的格式和结构。

数据标准化:将不同来源的数据进行标准化处理,以便于比较和分析。

实时数据处理技术

实时数据处理需要高效的技术来处理高速流动的数据。以下是一些常用的实时数据处理技术:

Apache Kafka:一个分布式流处理平台,用于构建实时数据管道和流应用程序。

Apache Flink:一个流处理框架,提供高性能和容错的实时数据处理能力。

Apache Spark Streaming:Apache Spark的一部分,用于实时数据流处理。

这些技术能够处理大规模的数据流,并支持复杂的数据处理逻辑,如窗口操作、状态管理和复杂事件处理。

数据分析与可视化

实时数据分析的最终目的是从数据中提取有价值的信息。以下是一些常用的数据分析方法:

统计方法:使用均值、方差、相关性等统计指标来分析数据。

机器学习:应用机器学习算法来发现数据中的模式和趋势。

实时预测:使用时间序列分析、回归分析等方法进行实时预测。

分析结果通常通过可视化工具展示,如Tableau、Power BI或D3.js等。这些工具可以帮助用户更直观地理解数据,并做出更明智的决策。

挑战与解决方案

实时数据分析面临一些挑战,包括数据质量、处理速度和复杂性。以下是一些解决方案:

数据质量:通过数据清洗和预处理来提高数据质量。

处理速度:使用高性能计算和分布式处理技术来提高处理速度。

复杂性:采用模块化和可扩展的设计原则来简化系统的复杂性。

通过克服这些挑战,实时数据分析能够为企业带来巨大的价值,帮助他们在竞争激烈的市场中保持领先。

结论

实时数据分析是一个复杂但至关重要的过程,它能够帮助企业快速响应市场变化,优化业务流程,并做出更明智的决策。通过采用合适的技术和方法,企业可以有效地从实时数据中提取有价值的信息,从而在竞争激烈的市场中脱颖而出。

转载请注明来自瑞丽市段聪兰食品店,本文标题:《实时数据怎么分析,实时数据分析框架 》

滇ICP备2023011059号-1

滇ICP备2023011059号-1